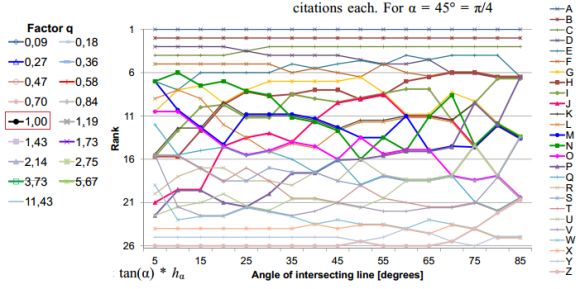

La arbitrariedad del índice h (propuesto por Hirsch en 2005) se hace evidente cuando se cambia un poco su definición y, en lugar de tomar el valor h como el número de publicaciones que han recibido al menos h citas cada una, se toma h como el número de publicaciones que han recibido al menos q*h citas cada una, donde q es distinto de la unidad; la costumbre es tomar q = tan(α), con q=1 para α=45 grados. El cambio parece muy pequeño, pero la estabilidad del índice h ante este «pequeño» cambio es pésima. El cambio en el orden (ranking) de una serie de investigadores al realizar un pequeño cambio en el valor de q es mucho más grande de lo que uno puede pensar en principio y hace dudar sobre la utilidad del índice h (con q=1) a la hora de ordenar investigadores por su producción. La figura muestra el ránking de 26 físicos en función del ángulo α entre 5 y 85 grados (obviamente, los primeros y últimos puestos cambian poco, pero la región intermedia, donde el índice h debe mostrar su utilidad práctica, es bastante «caótica»). Este resultado es bien conocido por los expertos en bibliometría, pero ignorado por el resto del mundo (todos los que usan el índice h a la ligera sin estudiar un «poquito» de bibliometría). Nos lo recuerda Michael Schreiber, «A Case Study of the Arbitrariness of the h-Index and the Highly-Cited-Publications Indicator,» Journal of Informetrics 7: 379-387, 2013 [arXiv:1302.6582].

Archivo por meses: febrero 2013

Tras dos años de análisis se descubre el secreto de la anomalía W+jj en los datos de CDF del Tevatrón (Fermilab)

Se han ofrecido muchas explicaciones para la anomalía W+jj observada en los datos del experimento CDF del Tevatrón en el Fermilab, cerca de Chicago. El otro experimento del Tevatrón, DZero no observó dicha anomalía; CMS y ATLAS del LHC en el CERN tampoco la observaron. Por tanto, la causa debe ser un «error sistemático» en los análisis de este tipo de colisiones. Ha costado dos años de intenso trabajo, basado en tres posibles hipótesis, hasta que se ha descubierto la razón. La técnica de Monte Carlo utilizada para el ajuste de los disparadores (triggers), utilizados en la identificación de los chorros, confunde cierto tipo de ruido de fondo con «supuestos» leptones (fake leptons), sobre todo electrones; reajustando la técnica de selección de eventos la anomalía W+jj desaparece y los datos corresponden a las predicciones del modelo estándar. Dos años de esfuerzos que han valido la pena. Había que encontrar el origen de este «error sistemático» pues podría afectar a otros análisis. ¿Afecta este cambio a otros análisis, como los del quark top o los del Higgs? El efecto es muy pequeño, despreciable en la práctica; así que no será necesario corregir los resultados publicados debido a la identificación errónea de los «supuestos» leptones. Nos cuenta la historia con detalles técnicos M. Trovato (on behalf of the CDF collaboration), «Update on dijet mass spectrum in W + 2jets events,» Wine & Cheese Seminar, Fermilab, Feb 23, 2013. El artículo técnico todavía no ha sido publicado en ArXiv, pero ha sido enviado a Physical Review D.

La esperanza (de encontrar la supersimetría) es lo último que se pierde

Dimitri V. Nanopoulos, físico teórico experto en supersimetría, lleva diez años prediciendo la masa del gluino (la (super)compañera del gluón). Conforme los experimentos descartan la masa que ha predicho, sube su predicción un poquito y vuelve a publicar una nueva estimación basada en más información que la anterior, con lo que, a priori, parece mucho mejor. Su última estimación es M½ = 765 ± 85 GeV. En su opinión, todos las búsquedas realizadas en el LHC hasta el momento son compatibles con este resultado. En las próximas semanas se publicarán en Moriond nuevas estimaciones experimentales (que casi seguro descartarán su predicción pues ya hay cierta evidencia que apunta a una masa M½ > 1200 GeV). No sé lo que ofrecerán los nuevos datos (tras el análisis de todas las colisiones de 2012), pero lo que es seguro es que Nanopoulos no perderá la esperanza y publicará nuevas estimaciones «optimistas.» Hasta que en 2015 no se publiquen los resultados de las primeras colisiones a 13 TeV c.m. en el LHC no se podrá descartar una masa M½ > 2000 GeV. Los interesados en los detalles (no muy técnicos) disfrutarán de Tianjun Li, James A. Maxin, Dimitri V. Nanopoulos, Joel W. Walker, «Correlated Event Excesses in LHC SUSY Searches at 7 & 8 TeV: New Physics or Conspiring Noise?,» arXiv:1302.6579, 26 Feb 2013. Más información crítica sobre este tema en Peter Woit, «The State of SUSY,» Not Even Wrong, Feb 27, 2013.

Los beneficios cognitivos de jugar a videojuegos violentos

Los videojuegos violentos (como Call of Duty o Unreal Tournament) se asocian a efectos negativos, como la obesidad, la agresividad, el comportamiento antisocial e incluso la adicción. Sin embargo, los neurólogos afirman que también tienen efectos beneficiosos en el cerebro, como aumentar la función de ciertas regiones del encéfalo y mejorar el bienestar general. Muchas habilidades cognitivas se refuerzan gracias a su entrenamiento continuo mientras se juega a este tipo de videojuegos, como la habilidad para ver pequeños detalles dentro de un conjunto desordenado de objetos, la capacidad para distinguir tonos de gris con mayor precisión, la de explorar entornos complicados o la de girar objetos tridimensionales complicados con la imaginación. Estas habilidades pueden ser útiles en muchas profesiones, como el diseño de compuestos químicos, la arquitectura o los servicios de rescate y emergencias. ¿Se pueden diseñar videojuegos para reforzar el aprendizaje controlado de ciertas habilidades cognitivas? Nos lo cuentan Daphne Bavelier, Richard J. Davidson, «Brain training: Games to do you good,» Nature 494: 425-426, 28 Feb 2013.

La galaxia NGC 1365 aloja un agujero negro supermasivo que rota al 84% de la velocidad máxima posible

Hoy en día se cree que todas las galaxias tienen una agujero negro supermasivo en su centro (su masa está entre millones y miles de millones de veces la masa del Sol). El nuevo telescopio espacial de rayos X de la NASA llamado NuSTAR (Nuclear Spectroscopic Telescope Array), lanzado el 13 de junio de 2012, ha determinado la velocidad de rotación del agujero negro supermasivo que se encuentra en el centro de la galaxia NGC 1365 (una galaxia cercana cuyo núcleo es activo) y resulta que es un 84% de la velocidad máxima permitida por los modelos teóricos. NuSTAR ha logrado obtener un espectro con una calidad sin precedentes de los fotones emitidos con energías entre 10 y 80 keV a partir del cual se ha podido estimar (utilizando modelos teóricos) la velocidad de rotación (hay que recordar que observaciones anteriores de los fotones con energías menores de 10 keV habían hecho sospechar que la velocidad del agujero negro era próxima a la máxima). Futuras observaciones deberán confirmar si estas velocidades tan grandes son las habituales o solamente una excepción. Nos lo cuenta Christopher S. Reynolds, «Astrophysics: Black holes in a spin,» Nature 494: 432-433, 28 Feb 2013, que se hace eco del artículo técnico de G. Risaliti et al., «A rapidly spinning supermassive black hole at the centre of NGC 1365,» Nature 494: 449-451, 28 Feb 2013 [arXiv:1302.7002].

Por qué se tituló «Dinámica de un asteroide» la obra del profesor James Moriarty en una novela de Sherlock Holmes

Sherlock Holmes califica la obra ficticia «Dinámica de un asteroide» del profesor James Moriarty con elogiosas palabras de admiración: «esta obra asciende a tales alturas técnicas en matemáticas puras que se dice que no hay científico en el mundo capaz de criticarla.» Según Alejandro Jenkins, el título fue elegido por Sir Arthur Conan Doyle como referencia a un panfleto satírico repartido en 1865 en la Universidad de Oxford por Lewis Carroll (autor de «Alicia en el país de las maravillas») titulado «The Dynamics of a Parti-cle.» Este panfleto de sátira política aprovechaba que en inglés «partido político» se dice «party» para hacer un juego de palabras con «parti-cle» (con guión explícito en el original). El panfleto tenía por objeto criticar a William Gladstone que se presentaba para su reelección en el «rectorado» («Parliament») de dicha Universidad. Carroll hacía un juego de palabras en el título con un texto científico (en la Inglaterra victoriana había muchos libros de texto titulados «Dinámica de una partícula,» destacando el famoso texto escrito para la Universidad de Cambridge por Peter Guthrie Tait y William J. Steele en 1856, que fue reimpreso 7 veces). La nueva hipótesis sobre el título contradice la propuesta de Isaac Asimov, según la cual el título aludía al movimiento de un asteroide genérico porque alrededor de 1875 (cuando se supone que lo escribió Moriarty) había mucho interés científico en este tema. Hay otras hipótesis, pero la nueva me parece muy sugerente, muy al estilo del genial Sir Arthur Conan Doyle. Más información en Alejandro Jenkins, «On the Title of Moriarty’s Dynamics of an Asteroid,» arXiv:1302.5855, 23 Feb. 2013.

PS: Gracias a un tuit de @ComandanteVimes me entero que «Asimov nunca pensó que el título se refiriera a un asteroide genérico. Lo desarrolla aquí.»

https://twitter.com/ComandanteVimes/status/306350079898431488

Por lo que parece, Asimov en «El Crimen Definitivo» propone que el tratado de Moriarty se refería al problema de los tres cuerpos (problema no integrable, que no posee solución analítica y presenta estocasticidad o caos hamiltoniano). Aun así, hay que tener cuidado, porque el problema del asteroide sujeto a las fuerzas del Sol y Júpiter es prácticamente plano, luego es un problema de tres cuerpos «degenerado» y las dificultades matemáticas del problema general se diluyen. Permíteme un extracto de «El Crimen Definitivo» de Asimov.

«En la novela El valle del miedo, Holmes menciona que Moriarty ha escrito una tesis titulada La dinámica de un asteroide, saturada de elementos matemáticos tan excéntricos y complejos que no había un solo científico europeo capaz de discutir el asunto. (…) Los teóricos se interesan en el problema de tres cuerpos y si Moriarty era un poderoso matemático, entonces justamente sobre eso debe de versar el tratado. (…) Hacia 1866, o algo así (estoy casi seguro que fue en 1866), descubrió el motivo. Cualquier asteroide cuya órbita pasara por esos huecos se habría movido alrededor del sol en un período igual a una fracción simple del período de Júpiter. (…) Un asteroide, cada dos o tres revoluciones, pasa a Júpiter bajo las mismas condiciones relativas de posición. La atracción de Júpiter es en una dirección particular cada vez, siempre la misma, ya sea hacia adelante o hacia atrás, y el efecto se acumula.»

El infrasonido del meteoro de Chelyabinsk y cómo se estimó su energía

Gracias a estos vídeos de youtube puedes oír el infrasonido producido por el meteoroide de Chelyabinsk, Montes Urales, Rusia, el pasado 15 de febrero. Esta grabación se obtuvo en la estación de la red CBTO (Comprehensive Test Ban Treaty Organisation) situada en la Antártida, a unos 15.000 km de distancia del evento. Grabaciones similares se obtuvieron en 17 estaciones de infrasonidos de la red CBTO. La entrada de un meteoroide en la atmósfera a velocidades hipersónicas y su posterior ablación producen una onda expansiva (onda de choque) que se propaga por la atmósfera y es audible a miles de kilómetros de distancia gracias a los infrasonidos. Estos sonidos no son audibles para el oído humano porque su frecuencias está en el rango de 0,001 a 20 Hz. Sin embargo, se puede modificar la frecuencia del sonido para hacerlo audible. Gracias a las medidas de la red de infrasonidos se puede estimar la posición (por triangulación), tamaño, masa, velocidad y energía liberada por el evento. Para ello se utilizan correlaciones experimentales obtenidas durante los últimos 60 años gracias a las pruebas de armas atómicas. En el caso del meteoro de Chelyabinsk se estimó que su diámetro fue de 17 metros, su masa de 10.000 toneladas y que liberó una energía equivalente a 500 kilotones de TNT.

Estas dos figuras muestran resultados medidos por la estación de infrasonidos I31KZ, situada a unos 600 km al sur del hipercentro (fuente). La señal observada tiene frecuencias entre 0,004 Hz y 8 Hz.

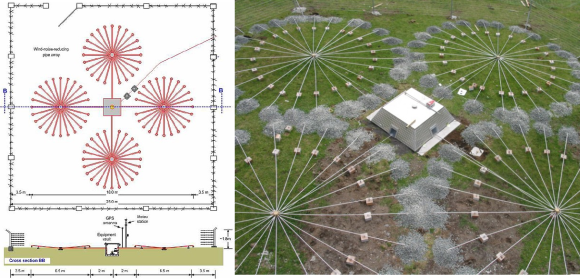

Esta fotografía muestra la estación británica IS49 (Tristan da Cunha); el cuadrado tiene un lado de 25 metros y las rosetas radiales un diámetro de 6,5 metros (click para ampliar).

¿Cómo se estima la energía del suceso a partir de la señal de infrasonidos? Se utiliza una ley de potencias empírica obtenida tras el análisis de las pruebas de armamento nuclear realizadas durante la Guerra Fría (sobre todo en la década de los 1950). Estas fórmulas son las recomendadas por la AFTAC (United States Air Force Technical Applications Center) y aparecen en el libro de A. Le Pichon et al., «Infrasound Monitoring for Atmospheric Studies,» Springer, 2010. Se asume un modelo ideal de la onda de choque (sonic boom) dado por una onda tipo N. El periodo de esta onda en segundos permite determinar la energía W en kilotones de TNT. Hay modelos físico-matemáticos más detallados, pero requieren conocer un gran número de parámetros que no suelen estar disponibles.

La teoría más sencilla para describir el movimiento de un meteoro que no se fractura durante su ablación fue desarrollada por Öpik (1933, 1937) y Whipple (1938). En estas fórmulas, m es la masa del meteoro, ρm es su densidad, v es su velocidad, S es el área de su sección transversal, Γ es el coeficiente de fricción con la atmósfera, ρ es la densidad de la atmósfera, Λ es el coeficiente de transferencia de calor (que mide la eficiencia de la transferencia al interior del meteoro del calor ganado por fricción), ξ es la energía de ablación del meteoroide (la energía necesaria para la ablación de una unidad de masa) y A es el llamado factor de cambio de forma. Estas fórmulas son aplicables a meteoroides con velocidades entre 11,2 km/s y 72,8 km/s, donde 11,2 km/s es la velocidad de escape de la Tierra y 72,8 km/s es la suma de la velocidad de escape del Sol a la distancia de la Tierra (42,5 km/s) más la velocidad orbital de nuestro planeta (30,3 km/s). En estas ecuaciones se ha despreciado el efecto de la gravedad en la trayectoria, pues el meteoroide atraviesa la atmósfera sólo durante unos pocos segundos, debido a su velocidad hipersónica. En el caso del meteoroide de Chelyabinsk estas fórmulas deberían ser corregidas con el efecto de la gravedad pues logró atravesar la atmósfera durante 32,5 segundos.

Los infrasonidos producidos por los meteoroides se llevan estudiando desde principios del siglo XX. Esta figura muestra una reconstrucción de la presión atmosférica sobre Europa el 30 de junio de 1908 cuando explotó a una altura de unos 10 km un meteoro sobre Tunguska en el centro de Siberia; se basa en las medidas de infrasonidos registradas en Washington DC que permitieron estimar que la energía liberada por este suceso fue equivalente a entre 10 y 12,5 megatones de TNT. Los infrasonidos permiten detectar el impacto de meteoros con un tamaño superior a pocos centímetros de diámetro. El registro observado permite estimar la masa del meteoroide, la velocidad de ingreso en la atmósfera y la energía total liberada por la desintegración del meteoro en la atmósfera.

La física detallada de procesos tan complicados como la ablación de un meteoro en la atmósfera está bien estudiada, pero en la práctica se utilizan modelos muy simplificados porque se ignoran gran número de los parámetros del meteoroide. Supongo que en los próximos meses se publicarán análisis detallados del suceso de Chelyabinsk. Ya os mantendré informados.

PS (27 feb 2013): Ya se han recogido gran número de fragmentos del meteoro de Chalyabinsk, aquí tenéis algunas fotografías.

PS (05 mar 2013): Recomiendo la lectura de T.A. Ens, P.G. Brown, W.N. Edwards, E.A. Silber, «Infrasound production by bolides: A global statistical study,» Journal of Atmospheric and Solar-Terrestrial Physics 80: 208–229, May 2012.

PS (05 mar 2013): Recomiendo la lectura de T.A. Ens, P.G. Brown, W.N. Edwards, E.A. Silber, «Infrasound production by bolides: A global statistical study,» Journal of Atmospheric and Solar-Terrestrial Physics 80: 208–229, May 2012.

.

Medidas de radar del asteroide 2012 DA14 mostrando su rotación

Este vídeo de la NASA muestra la rotación propia del asteroide 2012 DA14 gracias a medidas de radar realizadas por el Sistema de Radar Goldstone de la NASA entre el 15 y el 16 de febrero. La resolución alcanzada fue de 4 metros por píxel, pero se ve perfectamente cómo rota el asteroide con un periodo de unas 8 horas. Conocer en detalle esta rotación es fundamental para predecir su trayectoria futura (debido al efecto YORP, iniciales de Yarkovsky, O’Keefe, Radzievskii, y Paddack) y cuándo retornará a las cercanías de la Tierra.

Nota dominical: Qué teoría es la teoría BCS

La teoría microscópica de la superconductividad basada en pares de Cooper, llamada teoría BCS porque fue publicada por Bardeen, Cooper y Schrieffer en 1957 [1], no es una teoría microscópica en sentido estricto, sino una teoría fenomenológica, ya que no explica cómo se aparean los electrones gracias a la interacción con los fonones (vibraciones cuánticas de la red cristalina). En el artículo original se aproxima el potencial de atracción entre los electrones por una constante y se asume que la densidad de cuasipartículas (pares de Cooper) es constante en la superficie de Fermi; ambas hipótesis son válidas sólo de forma aproximada. Hoy en día hay varias teorías «microscópicas» que explican o justifican estas aproximaciones. De hecho, la teoría microscópica de la superconductividad, stricto sensu, aún no ha sido descubierta. Por tanto, el término «teoría BCS» no se refiere a una única teoría microscópica de la superconductividad, sino que agrupa a un cierto número de teorías alternativas todas ellas fenomenológicas en cierto grado. Nos lo cuentan en detalle Alexander M Gabovich, Vladimir I Kuznetsov, «What do we mean when using the acronym ‘BCS’? The Bardeen–Cooper–Schrieffer theory of superconductivity,» Eur. J. Phys. 34: 371–382, 2013.

En la teoría BCS todos los electrones apareados constituyen un sistema colectivo con una única función de onda coherente, con lo que las propiedades de cada par de Cooper son sólo una aproximación. Cada par se comportaría como una cuasipartícula (llamada «cuasimolécula» en el artículo original) de tipo bosón, pero la individualidad de dicho par hay que ponerla en entredicho, ya que la longitud de onda de coherencia asociada a la función de onda colectiva de todos los pares es del orden del micrómetro, enorme comparada con la distancia entre átomos de la red cristalina (aunque la longitud de coherencia en algunos cupratos, superconductores de alta temperatura, es mucho más pequeña, del orden de nanómetros). Por ello, en sentido estricto no se puede hablar de un solo par de Cooper, sólo de todo el conjunto de pares de forma colectiva.

Afirmar que el estado superconductor BCS es equivalente a un estado condensado de Bose-Einstein (BEC) de pares de Cooper es abusar del lenguaje, aunque muchos libros de texto lo hagan (y yo mismo en este blog lo he hecho alguna que otra vez). Usar el término «condensación cuántica» para aludir a la transición de fase superconductora puede ser engañoso para los estudiantes universitarios, postgraduados e incluso para físicos profesionales que no trabajan en los fundamentos teóricos de la superconductividad.

Otro punto importante a tener en cuenta es que la teoría BCS original era una teoría de acoplo débil entre los fonones y los electrones que se aparean, de tal forma que la red no se ve afectada. Sin embargo, en muchos casos el acoplo es fuerte y los electrones que se aparean en realidad corresponden a cuasipartículas (los llamados «fermiones pesados»), debido a los cambios que el acoplo introduce en la propia red cuyos iones se mueven de forma periódica alterando la superficie en el espacio de energía que define el nivel de Fermi.

Todas estas razones nos recuerdan que la teoría BCS original es fenomenológica y por tanto no debería ser llamada teoría microscópica (término que se mantiene por tradición). Para rizar el rizo, en teoría de la superconductividad se utilizan dos adjetivos «exótico» y «no convencional» para hacer referencia a los comportamientos de los superconductores no descritos por la teoría BCS que tienen su origen en la física microscópica subyacente. En opinión de Gabovich y Kuznetsov, se debe aclarar a los estudiantes estas cuestiones terminológicas para que pueden entender la teoría BCS y su rango de aplicabilidad. Más aún, hay que recordarles que la teoría microscópica de la superconductividad no existe todavía y por ello no se entienden los materiales superconductores a alta temperatura. Los jóvenes deben ser conscientes de ello. Bueno, y los no tan jóvenes…

¿Golpe fatal contra ENCODE y la «utilidad» del ADN «basura»?

Una de las grandes noticias científicas de 2012 fue la publicación de los resultados del proyecto ENCODE (ENCyclopedia Of DNA Elements), que reclamaban una «función» bioquímica para gran parte del mal llamado ADN basura («junk ADN» que no «garbage ADN»). Este resultado requería una revisión de ciertos aspectos de la teoría evolutiva y la genética, por lo que causó un gran enfrentamiento entre los expertos. Se han escritos muchos artículos en contra de la posible «función» del ADN basura, pero el definitivo es Dan Graur et al, «On the immortality of television sets: “function” in the human genome according to the evolution-free gospel of ENCODE,» Genome Biology and Evolution, AOP February 20, 2013 [copia gratis]. Me he enterado vía Robin McKie, «Scientists attacked over claim that ‘junk DNA’ is vital to life. Rivals accuse team of knowing nothing about evolutionary biology,» The Guardian, 24 Feb 2013, por lo que he buscado con urgencia a PaleoFreak (gran crítico de ENCODE en Twitter) y me he encontrado con un aplastante y demoledor «Golpe final al ENCODE (y viva el ADN basura),» 21 Febrero, 2013. Recomiendo su lectura, «no exenta de ironía y cierta crueldad.»

El nuevo artículo es contundente. El Consorcio ENCODE ha caído en una falacias lógica llamada afirmar el consecuente: Si A→B, y se da B, entonces se da A (lo correcto es el modus ponens: Si A→B, y se da A, entonces se da B). En concreto, los trozos de ADN que muestran una función biológica suelen mostrar ciertas propiedades, como se han observado trozos de ADN con las mismas propiedades, entonces dichos trozos de ADN tienen una función biológica (donde A=función y B=propiedad). Por ello, el Consorcio ENCODE ha publicado que más del 80% del genoma humano es funcional, es decir, que casi todos los nucleótidos tienen una función y que estas funciones se conservan evolutivamente sin sufrir selección. Todo indica que el proyecto ENCODE abusa del concepto «función» olvidando el último siglo de genética, que ha demostrado que sólo el 10% del genoma humano se ha conservado evolutivamente gracias a la selección; si fuera cierta la afirmación de ENCODE, el 70% del genoma humano sería invulnerable a mutaciones perjudiciales (un sinsentido en genética y teoría evolutiva). ENCODE ha caído también en la trampa de la apofenia, consistente en ver patrones y conexiones entre sucesos y datos aleatorios. Para ello han utilizado métodos experimentales que sobreestiman de forma consistente la posible «funcionalidad» de cada nucleótido.

En biología se pueden usar dos significados diferentes para la palabra «función» que no hay que confundir. Por un lado, la función seleccionada («selected effect» en el artículo de Graur et al.) que es resultado de la selección natural y se ha conservado porque permite al ser vivo estar mejor adaptado a su entorno. Y por otro lado, la función circunstancial («causal role» en el artículo de Graur et al.) que no tiene nada que ver con la selección y la evolución (por ejemplo, la función del corazón es bombear sangre, pero también tiene otras funciones circunstanciales, como producir sonidos, incrementar el peso corporal, etc.). El proyecto ENCODE abusa del concepto de función circunstancial al afirmar que un trozo de ADN tiene «función» si (1) es transcrito, o (2) está asociado a una histona modificada, o (3) está en una zona donde la cromatina está abierta, o (4) se acopla a factores de transcripción, o (5) contiene dinucleótidos CpG metilados. Estas funciones circunstanciales no son funciones seleccionadas y por tanto no son «funciones» en un sentido biológico estricto.

Una cuestión que permea el trabajo del Consorcio ENCODE es la función que tienen los intrones. Los genes en células eucariotas están divididos en intrones y exones, los primeros tras ser transcritos a ARN son «desechados» mientras que los segundos se unen entre sí para formar las secuencias de ARN mensajero que son traducidas a proteínas en los ribosomas. Los intrones no codifican proteínas y su papel biológico no está claro, por lo que la decisión del Consorcio ENCODE de marcarlos como «funcionales» es excesiva y muy discutible. Otra cuestión importante es el papel de los transposones, trozos de ADN que pueden moverse a lo largo del ADN y que constituyen alrededor del 30% del genoma humano y alrededor del 31% del transcriptoma humano. No está claro si algunos transposones tienen una «función» biológica, pero parece claro que la mayoría son simples parásitos, parásitos de parásitos y restos de parásitos. Asignarles una función no tiene sentido biológico.

Desde un punto de vista metodológico, el proyecto ENCODE cae en graves errores. Para comprobar si algo tiene o interviene en una función hay que eliminarlo y comprobar que la función desaparece o se modifica. Cualquier otra opción es incorrecta desde un punto de vista metodológico. El consorcio ENCODE cae en este tipo de errores constantemente.

¿Ha merecido la pena el proyecto ENCODE? ¿Servirá para algo todo el dinero gastado en este proyecto? Solo el tiempo lo dirá. En ciencia, como en las batallas, el reposo del guerrero es necesario para valorar la gesta.