«La «democratización» de la ciencia conduce a que no se investigue para conocer, sino para publicar. Si no hay publicación, no hay carrera científica. El lema publish or perish como esencia de la labor del científico.» Nos lo cuenta Félix M. Goñi, «Publicar a cualquier precio,» Revista SEBBM, Sep 2013, que edita un dossier con cuatro artículos titulado «Publicar a cualquier precio.» Recomiendo a todos que lean dichos artículos, merece la pena. Permíteme un breve resumen de cada uno.

Archivo de la etiqueta: Factor (o índice) de impacto

La prostitución intelectual que impone el sistema de revisión por pares

Muchos jóvenes científicos se quejan de que el proceso de revisión de por pares (peer review) les obliga a someterse a las exigencias de los revisores y les obliga a prostituirse intelectualmente. A nadie le gusta prostituirse, si puede evitarlo, pero la mayoría de los autores jóvenes tiene que aprender a vender su trabajo como una buena prostituta intelectual si quiere verlo publicado en buenas revistas. Aprender a hacer un buen servicio requiere llevarse muchos palos (artículos rechazados) o asociarse a un buen senior que tenga una dilatada experiencia (que nos enseñe las cosas que hacen disfrutar a los revisores). La comunidad científica, como toda sociedad, tiene muchas reglas, escritas y no escritas, a las que hay que atenerse. Nos guste o no nos guste, «soy una puta [intelectual] a mucha honra» es la frase que enarbolan en silencio la mayoría de los científicos de éxito. Recomiendo la lectura de Philip Pilkington, «Is Peer Review Forcing Academics to Become Prostitutes?,» Fixing the Economists, 24 Oct 2013, y del artículo de Bruno S. Frey, «Publishing as prostitution? – Choosing between one’s own ideas and academic success,» Public Choice 116: 205–223, 2003 [PDF gratis].

Cómo identificar la investigación relevante

La relevancia de un trabajo científico se puede medir gracias a su impacto. Publicar en Nature, Science, Cell y otras revistas de gran «factor de impacto» no es garantía de impacto, ni de relevancia. Expertos de la Universidad del Norte de Texas, en Dalton, han propuesto 56 medidas del impacto (pero algunas parecen «curiosas pero inútiles»). A la hora de usarlas para tomar decisiones, el gran problema es cómo integrar todas estas medidas de forma transparente, pues la transparencia es esencial en todo proceso de evaluación. Nadie sabe cómo hacerlo. Ni siquiera si es posible hacerlo. Identificar lo relevante, como lo excelente, parece fácil, pero no lo es. Nos lo cuenta el editorial «The maze of impact metrics. In deciding how to judge the impact of research, evaluators must take into account the effects of emphasizing particular measures — and be open about their methods,» Nature 502: 271, 17 oct 2013. Recomiendo consultar el número especial de Nature dedicado al impacto, merece la pena.

Descubierta una red de autocitas entre cuatro revistas brasileñas

Cuatro revistas brasileñas han perdido su índice de impacto en el último Journal of Citation Reports JCR 2012 de Thomson-Reuters y han sido puestas en cuarentena. Mauricio Rocha-e-Silva pensó que había descubierto la gallina de los índices de impacto. Desde 2009, junto a otros tres editores de revistas han estado publicando artículos que contienen cientos de citas a artículos de las revistas de los demás, cuyo único objetivo es incrementar su factor de impacto. Los algoritmos de análisis de autocitas de Thomson Reuters fueron engañados hasta el 19 de junio de 2013, el día que alguien descubrió la trampa. Con los nuevos algoritmos de análisis de autocitas se evitará que esto vuelva a ocurrir en el futuro. Por supuesto, Rocha-e-Silva, médico ya jubilado, ya no es editor de su revista, con sede en São Paulo (ha sido despedido por la editorial); sin embargo, los otros tres editores siguen en su puesto. Nos lo cuenta Richard Van Noorden, «Brazilian citation scheme outed. Thomson Reuters suspends journals from its rankings for ‘citation stacking’,» News, Nature 500: 510–511, 29 Aug 2013.

¿Corrompe el factor de impacto a los jóvenes científicos?

Hoy en día, un joven científico es evaluado en función del factor impacto de las revistas en las que publica y del número de citas de sus propios artículos. La calidad de su producción científica no se mide de ninguna otra forma. Por ello, muchos jóvenes científicos toman decisiones clave en su carrera académica en función del factor de impacto; decisiones tan importantes como en qué tema trabajar, en qué revista publicar y qué puestos académicos solicitar. La dependencia excesiva en el factor de impacto es perniciosa para los jóvenes, que son corrompidos por algo ajeno a la producción científica de calidad. Nos lo contaron Eve Marder, Helmut Kettenmann, Sten Grillner, «Impacting our young,» PNAS 107: 21233, Dec. 14, 2010.

Todo el mundo sabe, pero muchos olvidan, que el factor de impacto se inventó para ayudar a los bibliotecarios a decidir a qué revistas suscribirse. El factor de impacto da una idea aproximada de la influencia que tiene una revista científica en su campo. Utilizarlo para evaluar un individuo, un departamento, o incluso una institución es un abuso (como está demostrado en múltiples estudios). Como pasa con muchos asuntos pseudocientíficos, todo el mundo recuerda cuando funciona bien, pero se olvida muy fácil cuando falla de forma garrafal (y lo hace más a menudo de lo que a muchos les gustaría). Usarlo para evaluar a los científicos (jóvenes) no tiene ningún sentido, más allá del ahorro en costes (pues la evaluación la puede hacer una máquina en lugar de un par).

La actividad científica se entronca en la creación y la difusión de nuevos conocimientos. La revisión por pares debe cuestionar si un trabajo se ha realizado con rigor, aplicando los controles apropiados y un análisis estadístico correcto, si los datos y el texto son claros y suficientes para la replicación de los resultados, y si los argumentos expuestos tienen sentido lógico. Más aún, los revisores también ponen hincapié en la importancia potencial y en la novedad de la contribución. Como es de esperar, estos factores son los más relevantes para la aceptación del artículo en las revistas de alto factor de impacto. Pero la novedad es una navaja de doble filo, pues a veces se opone a la importancia; un resultado inesperado suele tener consecuencias difíciles de predecir. Muchas veces es un error premiar a los investigadores jóvenes en función de las novedades que se cruzan (por casualidad) en su carrera científica. Más aún, puede ser un grave error penalizar a los que tienen un proyecto robusto, de mayor importancia y de mayor impacto global, pero carente de novedades a corto plazo. La ciencia de calidad no debería basarse en «burros que han tocado la flauta.»

La hipocresía inherente a la elección del factor de impacto como única herramienta para medir la calidad científica socava los ideales que subyacen al avance científico. Muchos jóvenes brillantes y creativos se desilusionan y abandonan su carrera científica al ver que otros jóvenes, por pura suerte, copan los pocos puestos académicos disponibles. Hacer demasiado énfasis en las publicaciones en revistas de alto factor de impacto puede ser una receta desastrosa para el futuro de muchos jóvenes.

¿Existe alguna solución? Lo ideal sería reemplazar el factor de impacto como único indicador de excelencia y utilizar la evaluación por pares siempre que sea posible. Más aún, a ser posible, que dicha evaluación incluya científicos de prestigio internacional. Se requiere más tiempo y más esfuerzo, pero todos los científicos (senior) en activo deberían estar dispuestos a participar en estas evaluaciones porque esta es la única manera de liberar a los jóvenes científicos de la tiranía del factor de impacto.

La arbitrariedad del índice h a la hora de ordenar la producción de investigadores

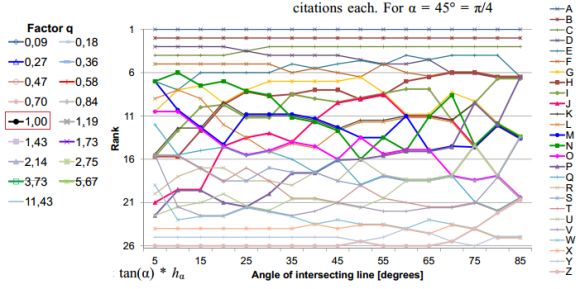

La arbitrariedad del índice h (propuesto por Hirsch en 2005) se hace evidente cuando se cambia un poco su definición y, en lugar de tomar el valor h como el número de publicaciones que han recibido al menos h citas cada una, se toma h como el número de publicaciones que han recibido al menos q*h citas cada una, donde q es distinto de la unidad; la costumbre es tomar q = tan(α), con q=1 para α=45 grados. El cambio parece muy pequeño, pero la estabilidad del índice h ante este «pequeño» cambio es pésima. El cambio en el orden (ranking) de una serie de investigadores al realizar un pequeño cambio en el valor de q es mucho más grande de lo que uno puede pensar en principio y hace dudar sobre la utilidad del índice h (con q=1) a la hora de ordenar investigadores por su producción. La figura muestra el ránking de 26 físicos en función del ángulo α entre 5 y 85 grados (obviamente, los primeros y últimos puestos cambian poco, pero la región intermedia, donde el índice h debe mostrar su utilidad práctica, es bastante «caótica»). Este resultado es bien conocido por los expertos en bibliometría, pero ignorado por el resto del mundo (todos los que usan el índice h a la ligera sin estudiar un «poquito» de bibliometría). Nos lo recuerda Michael Schreiber, «A Case Study of the Arbitrariness of the h-Index and the Highly-Cited-Publications Indicator,» Journal of Informetrics 7: 379-387, 2013 [arXiv:1302.6582].

La falta de rigor de Thomson Reuters al calcular el índice de impacto de una revista en el JCR

Ya hemos hablado en este blog en varias ocasiones de la «ingeniería» del índice de impacto, las artimañas que usan los editores de las revistas científicas para posicionarse mejor en el JCR (Journal Citation Reports) editado por la empresa privada Thomson-Reuters. Algunas «malas artes» son detectadas gracias a un algoritmo secreto (no publicado), sin embargo, otras se realizan con el consentimiento de Thomson-Reuters. Esta figura muestra cómo Current Biology subió un 40% en su índice de impacto gracias a cambiar el número de artículos que publicó en 2001: según el 2002 JCR publicó 528 artículos en 2001, pero según el 2003 JCR publicó sólo 300, ¿dónde fueron a parar los 228 artículos restantes? Las revistas científicas publican artículos de diferentes tipos (editoriales, noticias, letters, papers, reviews, book reviews, etc.). Todos pueden recibir citas, pero muchos reciben pocas citas. Los editores pueden solicitar a Thomson-Reuters que no tenga en cuenta ciertos tipos en su cuenta del número de artículos publicados. En el caso de Current Biology, este cambio supuso un incremento del 40% en el índice de impacto entre 2002 y 2003 (según Scimago, el SJR de Current Biology subió de 4,9 a 5,2, sólo un 6%). Supongo que los autores de artículos científicos que publicaron en esta revista en 2003 estarán muy contentos, pero los que publicaron en 2002 se lamentarán de que Thomson-Reuters no hiciera el cambio un año antes. ¿Saben las agencias de evaluación de investigadores y proyectos de la existencia de estos hechos? ¿Deberían ser tenidos en cuenta? Recomiendo la lectura del artículo de Björn Brembs, Marcus Munafò, «Deep Impact: Unintended consequences of journal rank,» arXiv:1301.3748, 16 Jan 2013.

Por cierto, el «índice de impacto» a veces es traducido del inglés como «factor de impacto» porque en dicho idioma se escribe «impact factor,» pero esta traducción, aunque es muy popular hoy en día, no era la recomendada hace 25 años cuando yo empecé a escuchar el término; igual que tampoco se usaba la palabra «tecnología» en lugar de «técnica,» la traducción correcta de «technology.» Pero como la lengua es algo vivo y cambiante, lo mismo alguno me criticará por seguir llamando «índice de impacto» a lo que siempre se llamó «índice de impacto» y ahora nos quieren imponer como «factor de impacto.»

En ciencia no hay mala publicidad: Los artículos más criticados alcanzan un mayor impacto

Muchos científicos odian que se critique su trabajo, pues piensan que ello conlleva un bajo impacto y bajo número de citas. Sin embargo, los análisis bibliométricos afirman todo lo contrario. Filippo Radicchi (Universitat Rovira i Virgili) ha estudiado el número de citas de los artículos en 13 revistas importantes y ha descubierto que los más criticados (con comentarios enviados al editor que se publican en la propia revista) son más citados en media; además, entre los artículos más citados de cualquier revista siempre hay un alto porcentaje de artículos que han sido «comentados» (o criticados). El dicho popular «Que hablen de mí, aunque sea mal» adquiere todo su sentido en el mundo de las publicaciones científicas. Más aún, el estudio de Radicchi apoya la hipótesis de que las disputas y críticas entre científicos son claves para la producción y difusión del conocimiento, y para el avance de la ciencia. El artículo técnico es Filippo Radicchi (Universitat Rovira i Virgili, Tarragona, Spain), «In science «there is no bad publicity»: Papers criticized in technical comments have high scienti c impact,» arXiv:1209.4997, Subm. 22 Sep 2012.

La controversia científica es parte coyuntural del progreso científico. Grandes avances científicos del pasado, como el modelo heliocéntrico de Copérnico, la teoría de la evolución de Darwin o la deriva de los continentes de Wegener, han estado rodeados de disputas, críticas y controversias de todo tipo. Por supuesto, muchas investigaciones controvertidas acaban en el olvido o siendo rechazadas, como la fusión fría o la memoria del agua. Aún así, lo que parece claro de la historia de la ciencia es que los cambios revolucionarios suelen ser polémicos y encuentran cierta resistencia antes de ser aceptados.

Fracción de artículos comentados que forman parte del 5% de los artículos más citados (círculos rellenos). Se compara con las predicciones estadísticas de un modelo que no diferencia entre artículos comentados y no comentados.

Los comentarios o cartas al editor en muchas revistas son el medio por el cual los científicas demuestran sus críticas al trabajo publicado por otros. Estos comentarios son considerados por los editores de las revistas como cualquier otro artículo y pasan por una revisión por pares. Hay comentarios positivos que aclaran o complementan el artículo comentado, pero la mayoría suelen ser críticas a las conclusiones o a la metodología utilizada. Normalmente, estos comentarios críticos suelen ir acompañados de una respuesta por parte de los autores (una deferencia muy habitual entre todos los editores). Por tanto, una manera automático de detectar comentarios críticos es considerar los comentarios que van acompañados de una respuesta de los autores. Utilizando esta regla, Radicchi ha estudiado el número de citas recibidas en la base de datos del Web of Science por los artículos de 13 revistas que han recibido «críticas.» Por ejemplo, en Physical Review Letters, el artículo más citado (más de 20.000 citas) fue un artículo criticado. Solo el 3% de los artículos han sido comentados, pero los 5 artículos más comentados están entre los 16 más citados de esta revista. Lo mismo pasa en las demás 12 revistas estudiadas (Nature, Science, Phys. Rev., etc.), los 5 artículos más comentados siempre están en el top de los más citados.

Por supuesto, el estudio de Radicchi tiene muchas limitaciones, entre ellas, que no se incluyen todas las posibles críticas a un artículo, solo las publicadas como comentarios (con respuesta de los autores) en la propia revista. Un análisis más riguroso requeriría estudiar qué artículos que citan al artículo lo hacen criticando sus conclusiones. Radicchi tiene mucho trabajo por delante investigando en dicha línea.

Los editores «lobos» que corrompen a la «Caperucita» de los autores con revistas de acceso gratuito

Lo he comentado muchas veces en este blog, el pagar por publicar (pay-per-publish) de muchas revistas de acceso gratuito está generando comportamientos poco éticos tanto de los editores como de los propios autores. Las editoriales y los editores ven un negocio redondo (en la India aparecen cada semana nuevas revistas que tratan de aprovecharse de los autores). Y los autores ven una oportunidad única para publicar con una revisión por pares «ligera» muchos artículos, con auto-plagios, plagios y muchos otros comportamientos poco éticos. Ya se sabe que el cliente siempre tiene la razón. Jeffrey Beall (autor del blog «Scholarly Open Access«) lo denuncia en «Predatory publishers are corrupting open access,» Nature 489: 179, 13 September 2012. Por cierto, ya nos hicimos eco de la labor de Beall en este blog: «La lista de “lobos” entre las editoriales de revistas de acceso gratuito,» 31 enero 2012.

Hoy se ha publicado el nuevo JCR 2011 de Thomson Reuters

Como todos los años, me hago eco de la publicación del nuevo Journal of Citations Reports (2011 JCR Science Edition). Los que publicamos artículos, tenemos la obligación de actualizar los índices de calidad de nuestras publicaciones aparecidas en 2011, que hasta hoy solo tenían información sobre 2010. Nature (36,280) vuelve a estar por encima de Science (31,201), algo que ya viene ocurriendo desde 2007. España cuenta con 78 revistas (en el Science JCR), cuando en el 2010 JCR solo tenía 73. Como ya sabéis me gusta la categoría de ciencia multidisciplinar, os dejo los primeros 10 puestos.

Como bien sabéis la utilidad del 2011 JCR está en la comparación de revistas dentro de un área de conocimiento concreta. Las comparaciones generales son odiosas. A los que tengáis acceso en España (vía la FECYT) os animo a ojear las categorías que más os atañan, aunque sin olvidar que no debemos abusar del índice de impacto (aunque la ANECA lo haga por nosotros).

En mi área de conocimiento «natural,» que es MATHEMATICS, APPLIED, vuelve a reinar SIAM Review con una diferencia cada más abultada (pasa de 6,620 a 10,020). Me alegra, porque ha habido desviaciones no deseadas en los últimos años (gracias a la ingeniería del índice de impacto por parte de los editores de ciertas revistas de «segunda»). Revistas «patológicas» como Chaos, Solitons & Fractals vuelven al redil (después de estar por encima de 3 hasta 2009, fictioso, obviamente, ahora tiene 1,222, cuando tuvo 1,268 en el 2010 JCR, un valor mucho más natural para el impacto real de esta revista); o como el International Journal of Nonlinear Scienes and Numerical Simulation que lleva una caída abismal como muestra la siguiente figura (en mi opinión su índice de impacto natural es del orden de la unidad, no más y porque publican en ella muchos «lobbies» de chinos).

Por cierto, ¿cómo ha quedado PLoS ONE, la gran revista de acceso gratuito en la que todo el mundo quiere publicar? La aprovecharé para explicar qué es el índice de impacto, que quizás mucha gente no conoce o no recuerda cómo se calcula.

El cálculo del índice de impacto es muy sencillo. Se suman todos los artículos publicados por la revista en los dos últimos años (en el 2011 JCR serán 2010 y 2009); en el caso de PLoS ONE son 11.125, sí has leído bien, más de once mil artículos. Se suman el número de artículos publicados en 2011 en revistas del 2011 JCR que han citado a algún artículo de la revista publicado en 2009 o 2010. En el caso de PLoS ONE, 45.521 artículos de 2011 (tanto de PLoS ONE como de otras revistas) han citado a los anteriores artículos. Finalmente, se obtiene el índice de impacto como el cociente entre ambos números. En el caso de PLoS ONE resulta 4,092, lo que no está mal.

Lo importante es la posición de la revista en las categorías (o áreas de conocimiento) a las que pertenece. En el caso de PLoS ONE solo pertenece al área de BIOLOGY y se encuentra en la posición número 12 de un total de 84, es decir, en el primer cuartil. Por cierto, en este área la revista mejor impactada es PLoS Biology, que alcanza un índice de impacto de 11,452.

Bueno, no sé qué más decir; además ahora tengo que actualizar mi currículum vitae.

PS (29 junio 2012): Álvaro Cabezas, «Las revistas españolas en los JCR 2011,» Primer Cuartil (Q1), 29 Junio 2012, nos recuerda que «Los JCR de Thomson Reuters recogen este año el índice de impacto de 10.677 publicaciones, de los cuales 528 lo reciben por vez primera. Son 127 las revistas españolas incluidas, en concreto 78 revistas corresponden al índice de Ciencias (SCI) y 54 al de Sociales (SSCI), cinco están en ambos índices, lo que significa en el caso del SCI cinco y en el del SSCI seis revistas más que el año anterior. (…) El dato anómalo en lo que respecta a las revistas españolas lo encontramos este año en la Revista de Psicodidáctica, editada por la Universidad del País Vasco, que ha aumentado su factor de impacto espectacularmente, desde el 0,815 hasta el 2,667, alzándose a la sexta posición en su categoría (Psychology, Educational). (…) A nivel internacional, por vez primera una revista supera los 100 puntos de factor de impacto (CA – A Cancer Journal for Clinicians; 101,780); [además] PLoS One, pese a su absurda política de publicación indiscriminada se mantiene con un índice por encima de cuatro. (…) Finalmente, la polémica este año la podemos tener con la desconocida revista turca Energy Education Science and Technology que alcanza un impacto de más de 31 puntos, por encima de Science, y que con una evidente falta de escrúpulos (autocitación del 90% y vida media de citas de solo 1,5 años) es la candidata número uno a ser expulsada del ISI ipso facto.»

PS (30 junio 2012): Los interesados en ver el listado de todas las revistas incluidas en el JCR pueden consultar este PDF. Las nuevas revistas que han sido incluidas aparecen en este otro PDF. Como nos cuenta Richard Van Noorden, «Record number of journals banned for boosting impact factor with self-citations,» Nature News Blog, 29 Jun. 2012, «Thomson Reuters ha excluido este año 51 revistas del 2011 JCR, cuando solo fueron excluidos 34 en 2010, 26 en 2009, 20 en 2008, y solo 9 en 2007. Casi todos han sido excluidos porque tienen un número excesivo de autocitas (“an anomaly in citation stacking”). Hay 140 revistas con un índice de autocitas superior al 70% que están en la sala de espera. ¿Cuál es el número normal de autocitas? 4/5 de todas las revistas tienen un porcentaje de autocitas menor del 30%.

Un ejemplo de cómo funciona la exclusión por autocitas. La revista Journal of Biomolecular Structural Dynamics (JBSD) ha sido excluida del 2011 JCR porque su índice de impacto subió de 1,1 en 2009 hasta 5,0 in 2010. Thomson Reuters solicitó al editor que explicara la razón de su éxito. Por lo que parece el editor decidió en 2009 recomendar a todos los autores de nuevos artículos que relacionaran su trabajo con el presentado en artículos recientes publicados en JBSD (supuestamente con objeto de mejorar la formación de los jóvenes estudiantes de doctorado que empiezan a leer la revista). Obviamente, la revista ha sido excluida del 2011 JCR por mala praxis del editor. El editor ha decidido cambiar de política (ya no apoyará la formación de los jóvenes doctorandos) y espera que dicho cambio le permita volver a entrar en el JCR (durante un par de años estará siendo vigilada y si corrige su mala praxis volverá a entrar en 2012 o en 2013).

Para los españoles que leen esto, les recuerdo que desde la ANECA todavía no han descubierto que el JCR incluye el índice de impacto de las revistas sin autocitas; espero que no lo descubran (por si acaso).

PS (01 julio 2012): En las revistas españolas también hay ingeniería del índice de impacto: Topo, «JCR 2011. Todo se pega. Ahora le toca manipular a la Revista de Psicodidáctica,» Un nombre al azar, Julio 01, 2012.