¿Qué es un cristal? Un sistema de átomos cuyo estado de mínima energía es periódico en el espacio. Un cristal de tiempo es un sistema de átomos cuyo estado de mínima energía es periódico tanto en espacio como en tiempo. Quizás habría que llamarles cristales de espacio y tiempo, o simplemente cristales oscilantes, pero Frank Wilczek, en un alarde de genialidad, ha decidido llamarles cristales de tiempo. Un nombre realmente sugerente. Sus dos últimos artículos en Physical Review Letters estudian la física clásica y la física cuántica de los cristales de tiempo. Lo más sorprendente es que se publica en el mismo número de PRL un artículo que presenta un esquema de cómo se puede fabricar un cristal de tiempo utilizando trampas magnéticas anulares de iones a muy baja temperatura, similares a las utilizadas por Wineland, Premio Nobel de Fïsica 2012; en esta propuesta, los iones forman un cristal debido a su repulsión eléctrica de Coulomb y rotan de manera permanente en el estado fundamental debido al campo magnético aplicado mediante técnicas láser. Según los autores, la rotación permanente de los átomos es robusta y podría ser observada mediante experimentos. Con el Premio Nobel de Física aún fresquito sobre estas tecnologías, muchos físicos experimentales ya estarán pensando en cómo implementar estas ideas y ser los primeros en lograr fabricar cristales de tiempo (o cristales de espacio y tiempo, nombre preferido por Tongcang Li et al.). Nos lo cuenta Jakub Zakrzewski, «Viewpoint: Crystals of Time,» Physics 5: 116, October 15, 2012, que se hace de los artículos de Alfred Shapere, Frank Wilczek, «Classical Time Crystals,» Phys. Rev. Lett. 109: 160402, October 15, 2012 [PDF gratis], Frank Wilczek, «Quantum Time Crystals,» Phys. Rev. Lett. 109, 160401, October 15, 2012 [PDF gratis], y Tongcang Li, Zhe-Xuan Gong, Zhang-Qi Yin, H. T. Quan, Xiaobo Yin, Peng Zhang, L.-M. Duan, Xiang Zhang, «Space-Time Crystals of Trapped Ions,» Phys. Rev. Lett. 109, 163001, October 15, 2012 [PDF gratis].

La idea de Frank Wilczek parte de uno de los temas de moda hoy en día, la rotura espontánea de la simetría (que es el fenómeno responsable de que el campo de Higgs cambie de propiedades por debajo de cierta energía crítica y se acople a todas las partículas fundamentales dándoles masa). En la rotura de la simetría significa que la solución (estable) a una ecuación matemática tiene menos simetría que una solución genérica a dicha ecuación (o si se prefiere, que las soluciones que preservan toda la simetría son inestables y decaen en soluciones estables que pierden parte de dicha simetría). No hay que irse a la teoría cuántica de campos para observar este ubicuo fenómeno, por ejemplo, las órbitas elípticas de Kepler para un planeta en el campo gravitatorio con simetría esférica producido por el Sol son un ejemplo de rotura de la simetría, pues las órbitas no tienen la simetría esférica del campo. En este caso no se trata de una rotura espontánea de la simetría porque la palabra «espontánea» se usa cuando el fenómeno le ocurre al estado fundamental (o de mínima energía) de la teoría.

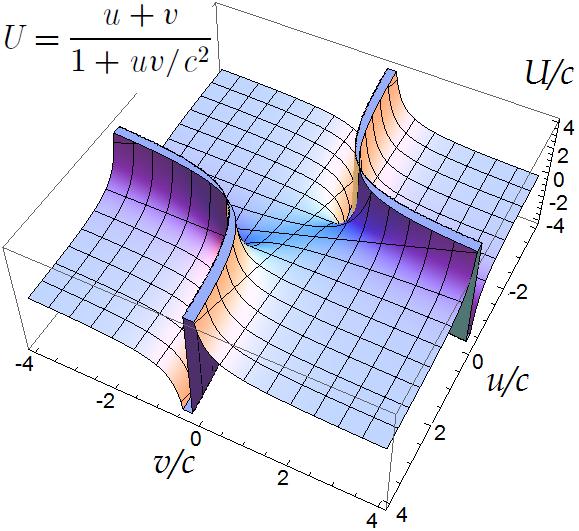

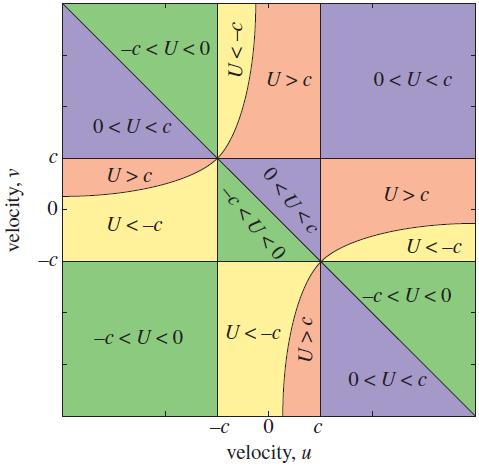

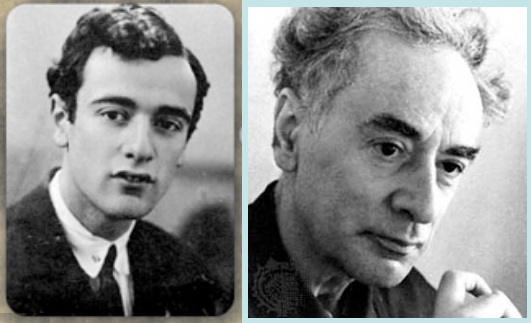

En la Naturaleza, el ejemplo más conocido de rotura espontánea de la simetría son los cristales, en los que la simetría continua de traslaciones de los átomos en el espacio está rota y en su lugar aparece la simetría discreta periódica del cristal. Alfred Shapere (Univ. Kentucky, Lexington, EEUU) y Frank Wilczek (Massachusetts Institute of Technology, Cambridge, EEUU) proponen que la rotura espontánea de la simetría también permite que el estado fundamental de un sistema clásico de átomos puede ser periódico en tiempo, de manera similar a como en un cristal es periódico en espacio, a lo que llaman cristales clásicos de tiempo. En estos sistemas, los átomos en el estado fundamental se encuentran oscilando o rotando de forma periódica. Puede parecer que es imposible lograrlo, ya que el estado de mínima de energía de un sistema que puede rotar debería ser no rotar (estar quieto), pero si la relación entre la velocidad y el momento es no lineal, la energía puede ser una función multivaluada del momento y tener un mínimo en el que la velocidad no es cero. Obviamente, el problema es descubrir un sistema real que tenga una relación entre la velocidad y el momento tan exótica como para ser no lineal.

Frank Wilczek en un segundo artículo extiende esta idea a los cristales de tiempo cuánticos y descubre que hay fenómenos cuánticos que permiten que el estado fundamental se encuentre rotando u oscilando. Para ello considera un sistema anular descritos por una ecuación de Schrödinger no lineal cuyas soluciones de tipo solitón (ondas solitarias que mantienen su forma al propagarse) pueden acoplarse a un campo magnético externo de tal forma que en el estado fundamental dichos solitones rotan de forma permanente. Wilczek nos propone que un anillo superconductor que puede soportar una corriente eléctrica permanente en su estado de mínima energía podría permitir una realización física de este sistema gracias a que la fase superconductora se comporta como un condensado de Bose-Einstein que puede presentar solitones en ciertas circunstancias; obviamente, su propuesta es más teórica que práctica y Wilczek no considera los problemas de ingeniería que acarrea fabricar dicho sistema.

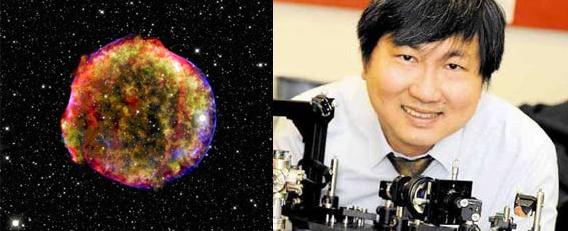

Una propuesta mucho más sencilla es la realizada por Tongcang Li (Univ. of California, Berkeley, EEUU) y sus colegas. Un sistema de átomos neutros con una interacción mutua atractiva (aunque sea débil) se puede acoplar un láser (con técnicas de óptica cuántica similares a las que han recibido el Premio Nobel de Física 2012) para emular el efecto de un campo magnético. Si estos átomos (por ejemplo, de berilio) se enfrían a muy baja temperatura hasta que se condensan en un estado de Bose-Einstein (para el berilio serían unos nanokelvin) en un trampa con forma de anillo (que el grupo de Wineland ya ha utilizado en alguno experimentos), el efecto del láser crearía vórtices en el condensado que se pondrían a rotar, emulando el movimiento de los solitones propuesto por Wilczek. El artículo de Li et al. explica bastantes detalles técnicos de su propuesto, a la vista de los cuales parece que es factible con las técnica actuales.

Zakrzewski nos recuerda que aunque los cristales de tiempo suenan próximos a una máquina de movimiento perpetuo, hay una gran diferencia: en los cristales de tiempo el movimiento periódico y eterno de los átomos ocurre en el estado fundamental del sistema y por tanto no se puede extraer trabajo (ni energía útil) de dicho sistema. La realización física de los cristales de tiempo no viola ninguna de las leyes de la termodinámica. ¿Para qué podrían servir entonces? Quizás podrían usarse como relojes a escala cuántica, aunque lo más interesante podría ser utilizarlos como análogos físicos para estudiar la rotura espontánea de la simetría en sistemas cuánticos.